AI后门日记(一)

防御方法专题

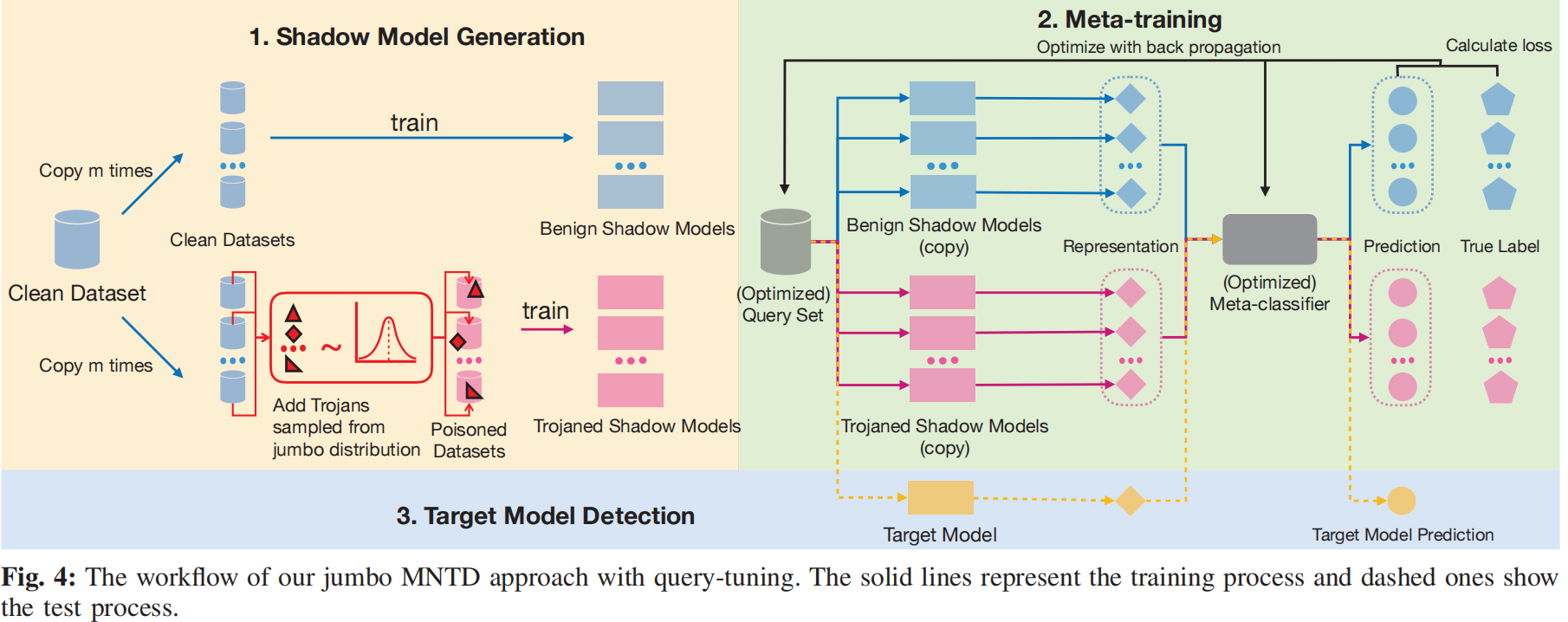

Detecting AI Trojans Using Meta Neural Analysis(MNTD)

论文源自2021IEEE S&P,该论文提出了元神经分析检测人工智能木马,该检测方法将待检测对象视为一个黑盒,只需要投喂一定的输入,根据输出的结果就可以判别是否含有后门。因此,该方法可以无视后门类型,数据集类型等,具有一定的普适性。

其检测步骤如下:

- (1) Shadow model generation.生成一堆干净或者带后门的模型。

- (2) Meta-training. 设计特征提取器去提取shadow models的特征并且训练meta-classifier去检测后门。

- (3) Target model detection.利用上述生成的提问和特征提取器进行检测。

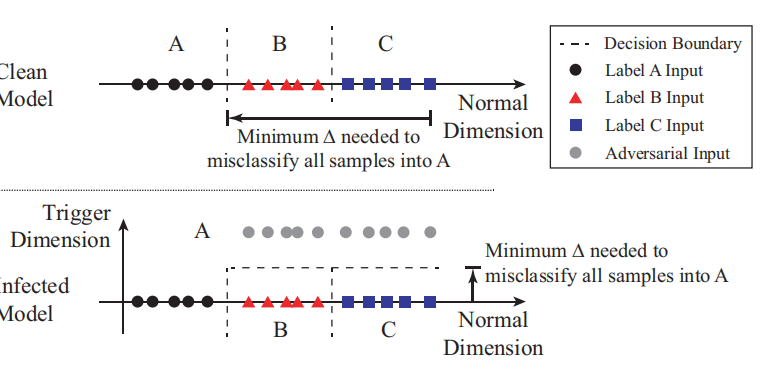

Neural Cleanse: Identifying and Mitigating Backdoor Attacks in Neural Networks(NC)

论文源自2019 IEEE S&P,是比较早期的后门检测环节方法,现在常用来做baseline。

其技术路线:

- (1) 检测后门。检测后门是使用异常指数来判断是否感染后门,值得注意的是 这种方法不适用于All2All,原因在MNTD论文中有说。检测原理为放所有标签通过,检查间距较小的哪个。

- (2) 重构触发器。重构触发器的方法是通过逆向工程来还原感染的触发器。

- (3) 实施缓解方法。包括: 输入过滤, 神经元修剪和后门关联的遗忘。

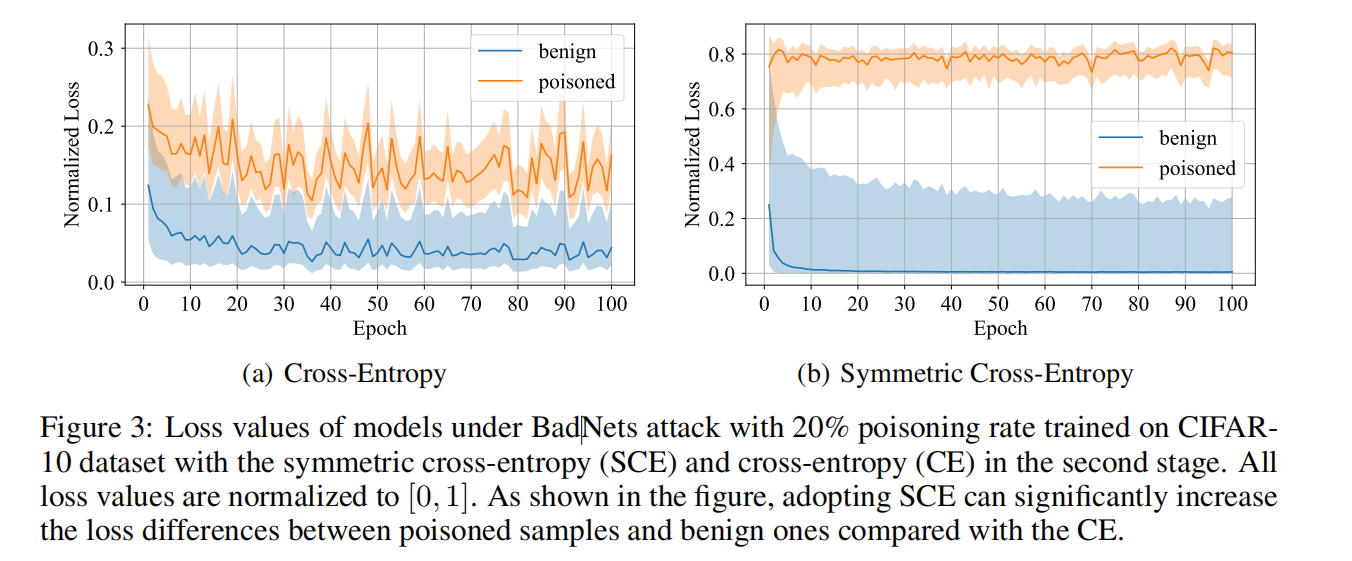

BACKDOOR DEFENSE VIA DECOUPLING THE TRAINING PROCESS(DBD)

论文源自ICLR2022。该论文提出的方法称为DBD(Decoupling-based Defense),包括三个阶段:

- (1) 自监督学习第一阶段去除所有标签,在未标记的训练集上训练。注意到,此时数据集是带毒但是没标签,所以不会学习到trigger和恶意标签之间的强关联性。

- (2) 通过标签噪声学习筛选高可信样本。根据观察到的正常样本和中毒样本的Loss不同来区分样本(这么做的文章不少)。

- (3) 通过半监督微调对模型进行微调。 利用高可信样本和低可信任样本的无监督版本进行半监督学习对整个模型进行微调。

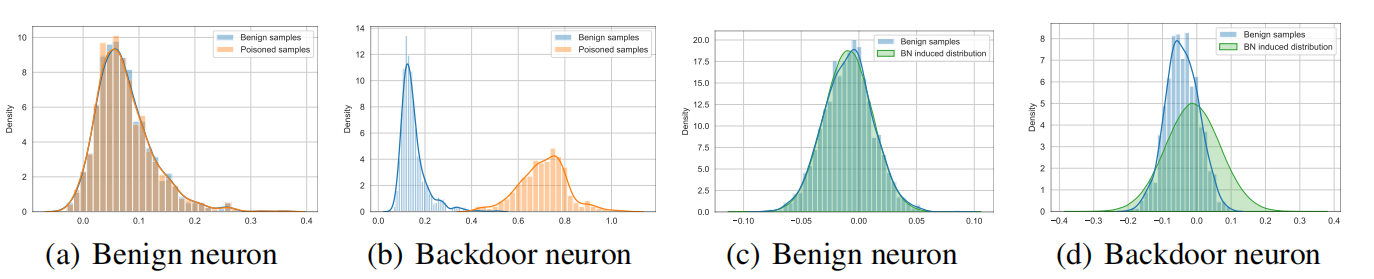

Pre-activation Distributions Expose Backdoor Neurons(EP&BNP)

论文来源NeurIPS 2022。改论文发现后门相关的神经元会被他们的预激活分布暴露,具体如下图所示:

由此提出了EP(Entropy-based pruning)和BNP(BN statistics-based pruning)来发现并修剪与后门高度相关的神经元。

Anti-Backdoor Learning: Training Clean Models on Poisoned Data(ABL)

ABL也是发现了有毒数据和健康数据在神经网络训练过程中的不同,不过和上面两种不同。这次ABL发现由于trigger一般干扰性较强,所以模型学习带有trigger的图片更快;此外,后门的目标往往仅限于某一个类(All2one)。

基于上述条件,ABL提出了一个两阶段的基于梯度上升的方案(该方案的目的是从恶意数据中学习出善意模型):

- (1) 在训练早期隔离后门样本。

- (2) 在二阶段打破后门样本和目标类之间的关系(unlearning)

Neural Trojans(Audo Encode defense)

2017年的远古论文。提出了如下技术路线:

输入异常检测:使用支持向量机(SVM)和决策树(DT)来检测不属于合法数据分布的输入样本。 重新训练:对神经IP进行更改,并使用仅来自合法数据的重新训练来覆盖权重中包含的特洛伊。 输入预处理:使用自编码器作为输入预处理器,防止非法输入触发特洛伊,同时不影响合法数据的分类准确性。

论文有点上年代了,还有传统ML方法。

Fine-Pruning: Defending Against Backdooring Attacks on Deep Neural Networks(FP)

论文来自RAID 2018,经典中的经典。提出了fp的思想,可以看到很多之后的文章继承了fp的思想,比如上面的 EP&BNP 和NC。

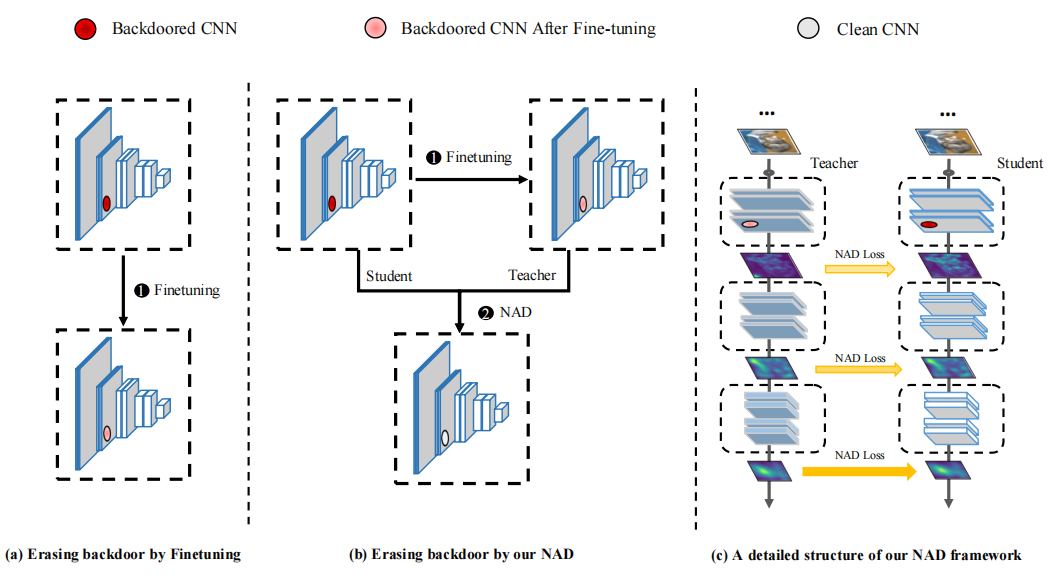

NEURAL ATTENTION DISTILLATION: ERASING BACKDOOR TRIGGERS FROM DEEP NEURAL NETWORKS(NAD)

论文来源ICLR2021。NAD也是fine-pruning based的方法。

NAD的流程图:

按文章说法,利用了KD和神经网络激活图和注意力图。即先从原本的学生模型中蒸馏出干净的较小的教师模型,然后合成出子模型。